Mesterséges intelligencia – Szabályok közt

A generatív mesterséges intelligencia (GenAI) az elmúlt években a “kísérleti laborokból” a mindennapi üzleti élet részévé vált. Ez a technológiai robbanás egy alapvető kérdést vetett fel: ki felügyeli a gépeket, és ki felel a tetteikért?

Az Európai Unió erre a kérdésre adta meg a világon elsőként átfogó, jogilag kötelező érvényű választ: ez az EU AI Act, vagyis a Mesterséges Intelligencia Törvény (hivatalos nevén: (EU) 2024/1689 rendelet).

Fontos tisztázni: a törvény célja nem a fejlődés megfékezése, hanem egy olyan keretrendszer létrehozása, amelyben az AI biztonságosan, átláthatóan és az alapvető emberi jogok tiszteletben tartásával működhet.

A szabályozás nem az algoritmusok matematikai mélységeit célozza, hanem azok társadalomra és egyénekre gyakorolt hatását.

Ezzel, a GDPR-hoz hasonlóan, az EU ismét egy globális sztenderdet teremthet, ami azt jelenti, hogy a szabályok előbb-utóbb az egész világon elterjedhetnek.

A törvény hatálya pedig kiterjed mindenkire, aki az EU piacán mesterséges intelligencia rendszert forgalmaz, használ, vagy akár csak annak kimenetét (outputját) hasznosítja – függetlenül attól, hogy a cég fizikailag hol található.

Ezért ez a cikk nem egy elvont jogi elemzés, hanem egy gyakorlati útmutató, ami segít megérteni, mit kell tenned neked és a cégednek, hogy felkészüljetek erre az új korszakra.

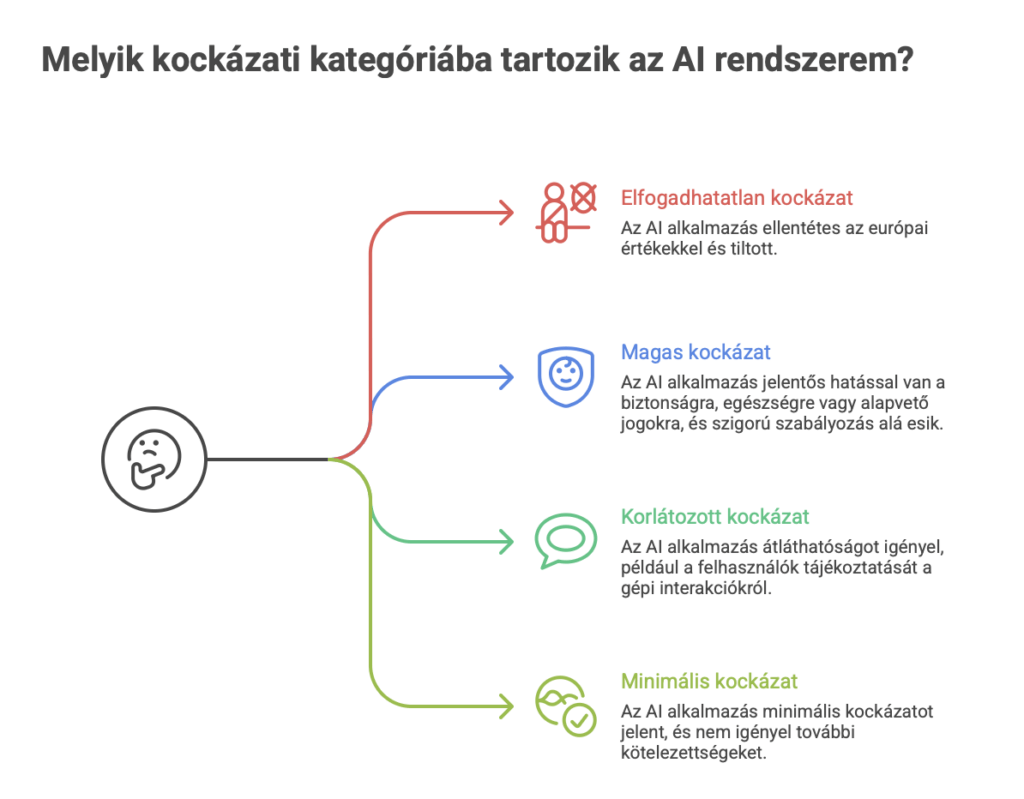

Az AI törvény gerince: Kockázatalapú megközelítés

A jogszabály központi logikája rendkívül egyszerű: minél nagyobb kockázatot jelent egy AI rendszer az emberekre, annál szigorúbb szabályok vonatkoznak rá. A törvény négy, jól elkülöníthető kategóriát határoz meg, amelyeket minden cégnek ismernie kell, hogy be tudja azonosítani a saját eszközeit.

Elfogadhatatlan kockázat (Prohibited)

Ezek azok az AI alkalmazások, amelyek annyira ellentétesek az európai értékekkel, hogy a törvény teljes mértékben tiltja őket. Ide tartoznak például:

- A tudat alatti manipulatív technikákat alkalmazó rendszerek.

- Az emberek sebezhetőségét (pl. kor, fogyatékosság, gazdasági helyzet) kihasználó AI-ok.

- Az államok által végzett, általános célú „társadalmi pontozó” rendszerek (social scoring).

- Az érzelemfelismerő rendszerek használata a munkahelyeken és oktatási intézményekben (kivéve, ha biztonsági vagy egészségügyi célokat szolgál).

Magas kockázat (High-Risk)

Ez a legszigorúbban szabályozott, de még engedélyezett kategória. Olyan rendszerek tartoznak ide, amelyek jelentős hatással lehetnek az emberek biztonságára, egészségére vagy alapvető jogaira. Két fő csoportjuk van:

- Olyan termékek biztonsági komponenseként működő AI, amelyek már eddig is szigorú ellenőrzés alá estek (pl. autók, orvosi eszközök, játékok).

- A törvény mellékletében (Annex III) külön felsorolt területeken használt rendszerek. Ilyen például a biometrikus azonosítás, a kritikus infrastruktúrák (pl. víz-, gáz-, áramhálózat) irányítása, az oktatás (pl. vizsgák automatizált értékelése), a foglalkoztatás (pl. önéletrajzokat előszűrő szoftverek), a hitelbírálat, vagy a bűnüldözés.

Ezekre a rendszerekre kőkemény követelmények vonatkoznak: folyamatos kockázatkezelést, magas minőségű adatokat, állandó emberi felügyeletet, részletes technikai dokumentációt és a kiberbiztonsági normáknak való megfelelést írják elő.

Korlátozott kockázat (Limited Risk)

Ezeknél a rendszereknél a legfőbb elvárás az átláthatóság. A felhasználóknak egyértelműen tudniuk kell, ha egy géppel kommunikálnak, vagy ha a tartalom, amit látnak, mesterségesen lett létrehozva. Ide tartoznak:

- A chatbotok – a felhasználót tájékoztatni kell, hogy nem emberrel beszél.

- A deepfake-ek és más, AI által generált vagy manipulált audio- és vizuális tartalmak (ezeket egyértelműen jelölni kell).

Minimális kockázat (Minimal Risk)

Ide tartozik a legtöbb ma használt AI alkalmazás, például az AI-alapú spam szűrők vagy a videójátékok intelligens karakterei. Ezekre a törvény nem ír elő semmilyen plusz kötelezettséget, bár a fejlesztők önkéntesen csatlakozhatnak különböző magatartási kódexekhez.

| Kockázati Szint | Fő Követelmény | Gyakorlati Példák |

| Elfogadhatatlan | TELJES TILTÁS | Társadalmi pontozó rendszerek, munkahelyi érzelemfelismerés, manipulatív technikák. |

| Magas | Szigorú megfelelés, dokumentáció, emberi felügyelet | Önéletrajz-szűrő szoftver, orvosi diagnosztikai AI, hitelképességet vizsgáló algoritmus. |

| Korlátozott | Átláthatóság, tájékoztatási kötelezettség | Chatbotok, deepfake videók, AI által generált képek és szövegek. |

| Minimális | Nincs kötelezettség (önkéntes kódexek lehetségesek) | Spam szűrők, AI a videójátékokban, készletoptimalizáló rendszerek. |

Céged új feladatlistája: kötelezettségek az AI használata során

A törvény a cégeket alapvetően két szerepkörbe sorolja: a “fejlesztő” (provider), aki létrehozza az AI rendszert, és az “alkalmazó” (deployer), aki azt használja a saját működése során.

KÉP: Fejlesztő vs alkalmazó cégek

A legtöbb magyar vállalkozás az utóbbi kategóriába fog tartozni, de ez nem jelenti azt, hogy mentesülnek a felelősség alól. Sőt, a felelősség megoszlik, és nem lehet mindent a fejlesztőre hárítani.

Az AI-t alkalmazó cég felelős azért, ahogyan a rendszert a saját környezetében, a saját céljaira használja.

Itt van egy rejtett kockázat: ha egy cég egy külső szolgáltatótól vásárolt AI eszközt jelentősen módosít, vagy a saját márkaneve alatt kezdi el használni, akkor a törvény szemében ő maga is “fejlesztőnek” minősülhet. Ez pedig azt jelenti, hogy a sokkal szigorúbb fejlesztői kötelezettségek (pl. a teljes technikai dokumentáció elkészítése) mind rá hárulnak.

Ezért a beszerzési és IT-integrációs folyamatokat ezentúl jogi és megfelelőségi szempontból is alaposan át kell gondolni.

Az “alkalmazó” cégek számára a legfontosabb teendők a következők:

- AI “leltár” készítése: Az első és legfontosabb lépés egy belső felmérés. Pontosan tudnod kell, hogy a céged hol, milyen területeken és milyen AI rendszereket használ vagy tervez bevezetni. Lehet, hogy olyan szoftverekben is van AI-komponens, amiről eddig nem is tudtál.

- Kockázati besorolás: A leltár alapján minden egyes rendszert be kell sorolnod a fentebb részletezett négy kockázati kategória valamelyikébe.

- Magas kockázatú rendszerek kezelése: Ha a céged magas kockázatú rendszert használ (pl. egy toborzási szoftvert), akkor egyértelmű teendőd van, biztosítanod kell a folyamatos emberi felügyeletet, a fejlesztőtől kapott dokumentáció alapján meg kell értened a rendszer működését és korlátait, és felelősséged, hogy a rendszerbe táplált adatok megfelelő minőségűek legyenek.

- Átláthatósági kötelezettségek betartása: Ha chatbotot üzemeltetsz az ügyfélszolgálaton, vagy AI-val generált képeket használsz a marketingben, gondoskodnod kell a felhasználók egyértelmű és azonnali tájékoztatásáról.

A rejtett kötelezettség, amiről sokan nem tudnak: AI Literacy

Miközben a legtöbb elemzés a kockázati kategóriákra és a technikai követelményekre fókuszál, a törvény tartalmaz egy kevésbé hangsúlyozott, de annál fontosabb elvárást is: az AI Literacy = “AI műveltség” előmozdítását.

Az EU-s rendelet kötelezően előírja az AI megoldást használó vállalkozások számára munkatársaik megfelelő szintű mesterséges intelligencia műveltségi képzését.

Gondolj erre úgy, mint az “új tűzvédelmi oktatásra” vagy a kötelező adatvédelmi (GDPR) tréningre. Ez már nem egy választható “soft skill”, hanem a felelős működés és a kockázatkezelés alapfeltétele.

Hogyan is tudna egy képzetlen munkatárs hatékony emberi felügyeletet biztosítani egy magas kockázatú rendszer felett, ha nem érti annak alapvető működését, korlátait és lehetséges torzításait? A válasz az, hogy sehogyan.

Az AI literacy tehát nem egy elszigetelt jogi pont, hanem a törvény egyik központi követelményének, az emberi felügyeletnek a gyakorlati előfeltétele.

A mulasztás következményei pedig brutálisak lehetnek. Az AI Act a GDPR-nál is szigorúbb bírságokat vezet be, amelyek a cég méretétől és a jogsértés súlyosságától függenek.

| Jogsértés Típusa | Maximális Bírság (EUR) | Maximális Bírság (Világpiaci Árbevétel %) |

| Tiltott AI gyakorlatok (Article 5 megsértése) | 35 000 000 EUR | 7% |

| Egyéb kötelezettségek megsértése (pl. magas kockázatú rendszerek előírásai) | 15 000 000 EUR | 3% |

| Helytelen, hiányos információ szolgáltatása a hatóságoknak | 7 500 000 EUR | 1% |

A 7%-os tétel, ami a cég teljes, világpiaci éves árbevételére vonatkozik, egyértelművé teszi, hogy a jogalkotó ezt a kérdést rendkívül komolyan veszi. A képzési kötelezettség elmulasztása tehát nemcsak egy adminisztratív hiba, hanem egy súlyos pénzügyi kockázat.

Hogyan tegyél eleget a képzési kötelezettségnek?

Miután világossá vált a jogi kötelezettség és annak súlya, a kérdés az, hogyan lehet ennek a legegyszerűbben és leghatékonyabban megfelelni. A megoldás egy célzott, a jogszabályi elvárásokra épülő képzés, mint például az AI Literacy e-learning kurzusunk.

Ennek a megközelítésnek a lényege a gyakorlati, jogi szempontból is védhető megfelelés.

- Célzott Tartalom: A kurzus pontosan azokat a témákat fedi le, amelyek a törvény által elvárt AI alapismeretek szükségesek: az AI alapvető működésének megértése, a technológia korlátainak és kockázatainak ismerete, valamint a felelős és tudatos használat képességének elsajátítása.

- Hatékonyság és skálázhatóság: Egy 2-3 órás, 100%-ban online, saját ütemben elvégezhető formátum lehetővé teszi, hogy egy cég az összes munkavállalóját gyorsan és a napi működés minimális megzavarásával képezze, legyen szó egyetlen munkatársról vagy akár több ezer főről.

- Dokumentálhatóság és igazolhatóság: Ez egy fontos szempont egy esetleges hatósági ellenőrzés során. Modern oktatási platformunkon nyomon követhető a részvétel, a sikeres teljesítésről kiállított elektronikus tanúsítvány pedig kézzelfogható bizonyítékként szolgál arra, hogy a cég munkatársa eleget tett a képzési kötelezettségének.

- Rugalmasság: Az alapvető megfelelésen túl lehetőség van a tudás elmélyítésére is. Cégre szabott gyakorlatorientált képzéseink segítségével a munkatársak nemcsak a szabályokat ismerik meg, hanem azt is, hogyan alkalmazzák az AI-t hatékonyan és biztonságosan a saját munkájukban.

Összegzés: Nem érdemes halogatni

Az AI Act nem a távoli jövő zenéje. A törvény már hatályba lépett, és a szabályok lépcsőzetesen válnak kötelező érvényűvé.

Ez a lépcsőzetesség nem véletlen: a jogalkotó egyfajta stratégiai türelmi időt ad a cégeknek a felkészülésre.

A legfontosabb határidők, amiket ismerned kell:

- 2025. február 2.: A tiltott AI rendszerekre vonatkozó szabályok hatályba lépnek. Ez az a dátum, amikortól a legveszélyesebb alkalmazásokat ki kell vezetni a piacról. Logikusan ez az a pont, ahol az alapvető tudatosságnak (AI literacy) is meg kell lennie a cégeknél, hogy egyáltalán felismerjék, mit nem szabad használni.

- 2025. augusztus 2.: Az általános célú AI (GPAI) modellekre (mint pl. a GPT-4) vonatkozó átláthatósági és dokumentációs szabályok életbe léptek.

- 2026. augusztus 2.: A törvény teljes egésze, beleértve a magas kockázatú rendszerekre vonatkozó legbonyolultabb előírásokat is, általánosan alkalmazandóvá válik.

Tudjuk, hogy ez elsőre sok információ lehet, ezért most az javasoljuk az első lépésként, hogy vegyétek fel velünk a kapcsolatot, hogy egy ingyenes, cégre szabott tanácsadás keretében átbeszéljük a ti helyzeteteket és a logikus következő lépéseket.

Ez nemcsak a potenciális büntetésektől óv meg, hanem megteremti a felelős és fenntartható digitális működés alapjait a cégeteken belül.